2. 中山大学地理科学与规划学院, 广东 广州 510275;

3. 湖南博通信息股份有限公司, 湖南 长沙 410007;

4. 珠海欧比特宇航科技股份有限公司, 广东 珠海 519000

2. Department of Geography and Planning, Sun Yat-Sen University, Guangzhou 510275, China;

3. Hunan Botong Information Co., Ltd., Changsha 410007, China;

4. Zhuhai ORBITA Aerospace Science & Technology Co., Ltd., Zhuhai 519000, China

随着城市建设的发展,建筑物成为地理数据库中最容易变化的部分。高质量的遥感影像成为建筑物提取的便利且高效的数据之一,相较于传统的基于光学特征的遥感影像的建筑物提取,计算机硬件和软件的成熟与神经网络的出现,使得基于高分辨率遥感影像的高精度、自动化建筑物提取成为当前的研究热点。

基于高分辨率遥感影像的建筑物提取,国内外学者已取得了较大程度进展,传统的方法多依据遥感影像的浅层特征[1-3]。文献[4]利用建筑物的形状、颜色、亮度、阴影、大小及高度的变化进行建筑物的提取。文献[5]采用几何信息高效检测并结合线段检测器提取建筑物,获取较好的建筑物提取结果。此外基于遥感影像的形态学建筑物指数[6]可有效提取建筑物,文献[7]基于此提出了增强形态学建筑物指数,并进行高分辨率遥感影像的建筑物提取。传统的遥感影像建筑物提取方法多是利用图像的浅层特征,无法利用图像深层特征的语义信息。卷积神经网络(convolutional neural networks, CNN)可利用遥感影像的深层特征进行图像分割,1989年LeNet[8]的诞生使得卷积神经网络出现在大众视野。文献[9]提出全卷积网络(fully convolutional networks, FCN), 首次采用深度学习的方法进行图像语义分割。文献[10]提出了U-Net, 该网络采用编码器-解码器-跳跃链接,有效提高了小目标分割精度。文献[11]提出了SegNet,该网络的解码器采用最大池化索引,实现了良好的分割效果。文献[12]基于FCN框架提出了金字塔场景解析网络(pyramid scene parsing network, PSPNet),其金字塔池化模块由文献[12]中提出, 聚合基于不同子区域获取图像的全局上下文信息,适用于复杂场景下的图像分割。为了解决网络深度的增加伴随梯度消失和梯度爆炸的问题,文献[13]提出了残差神经网络(residual network, ResNet), 网络深度越深,模型精度越高。基于深度学习的方法被广泛应用于遥感影像的建筑物提取[14-15]。文献[16]采用PSPNet进行了高分辨率遥感影像的城市建成区提取,精度可达83.1%;文献[17]提出了一种结合深度残差网络和金字塔式层级链接的高分辨率遥感影像建筑物提取方法,模型预测精度明显高于其他方法。前人的研究多采用航空数据,此类数据空间分辨率高、场景简单,而迁移至高分辨率遥感影像数据集时存在提取结果不完整,易误提取高层建筑物立面和低层建筑物提取结果精度低等问题,不适宜复杂场景下的建筑物提取。

针对以上问题,本文提出一种融合多特征改进型PSPNet模型。该模型采用编码器和解码器结构,在编码器之后增加膨胀卷积模块,通过不同膨胀率的膨胀卷积增大卷积的感受野,获取更多的图像特征信息,模型解码部分融合图像浅层特征,可保留图像中的小型建筑物目标。

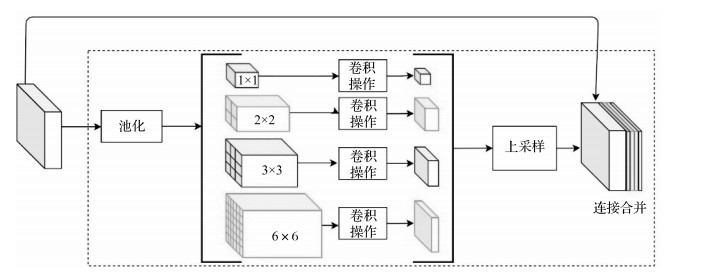

1 原理与方法 1.1 金字塔池化模块文献[12]于2017年提出的PSPNet,其金字塔池化模块融合了4种不同尺度下的图像特征,如图 1所示,对每个子区域进行平均池化操作,得到不同尺寸的特征图,经过1×1卷积后,通过上采样的方式还原特征图尺寸并融合,获取不同尺寸图像的特征信息,降低误分割概率。

|

| 图 1 金字塔池化模块 |

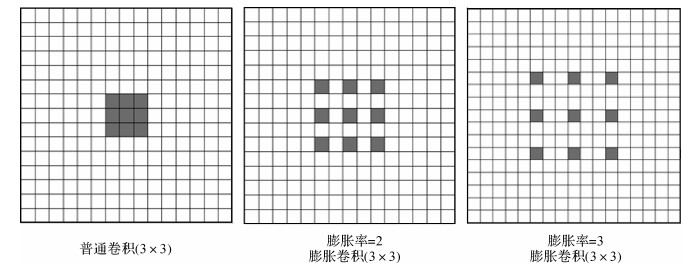

膨胀卷积通过普通卷积填充0的方式得到,使卷积在不改变参数大小的情况下获取更大的感受野和更多的图像特征信息,如图 2所示。

|

| 图 2 膨胀卷积 |

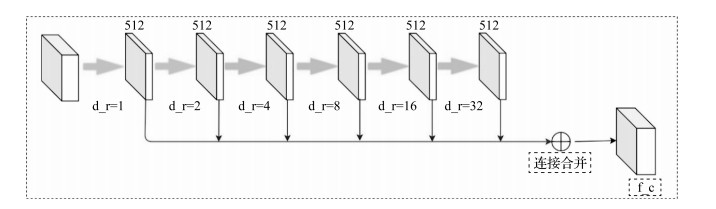

文献[18]于2020年提出膨胀卷积模块并应用于构建深度学习网络——建筑物残差修正网络,建筑物的分割结果精度得到有效的提升。通过增大分离层的感受野或融合深层特征和浅层特征可获取更多上下文信息,后者易于保存目标的细节信息。如图 3所示,膨胀卷积模块中使用了6个膨胀卷积,卷积核大小为3×3,膨胀率分别为1、2、4、8、16、32,将卷积后的特征图进行融合,可在不增加参数量的前提下,增加卷积核的感受野,用于获取图像中联系上下文信息和全局信息,丰富图像特征。

|

| 图 3 膨胀卷积模块 |

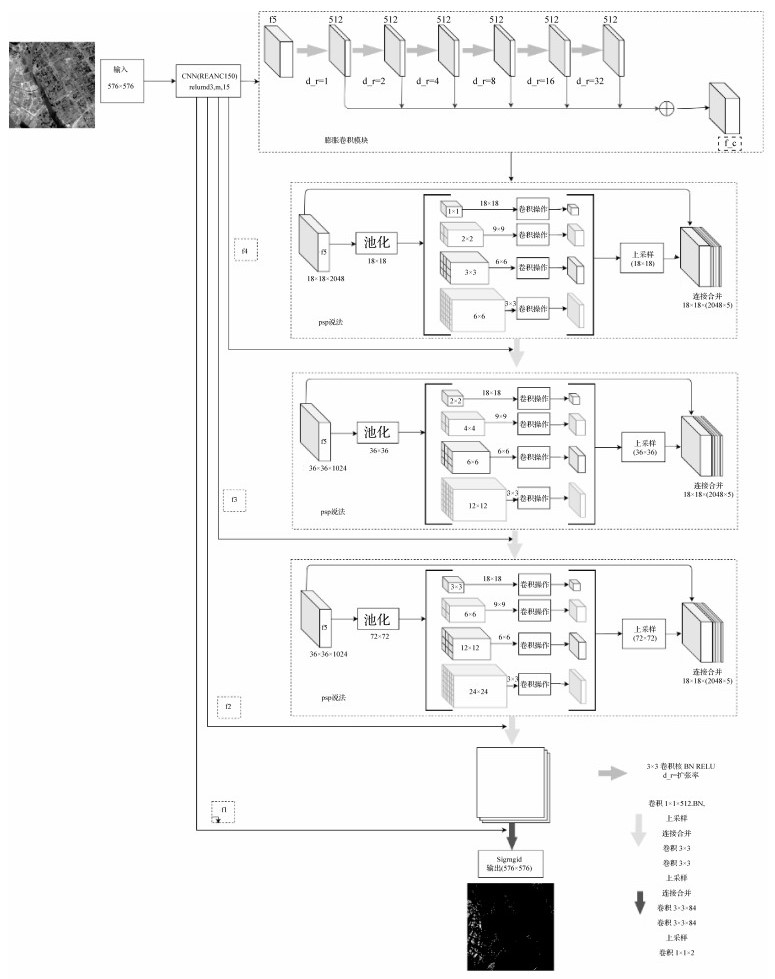

融合多特征改进型PSPNet网络分为3个部分,如图 4所示,第一部分是卷积神经网络ResNet50,该网络用于获取图像的浅层和深层特征图,用于后续解码部分的特征融合;第二部分是膨胀卷积模块,将经过CNN得到的特征图输入膨胀卷积模块中,获取全局信息和结合上下文信息;第三部分是金字塔池化模块,将通过膨胀卷积的特征图传入金字塔池化模块,进一步获取图像特征信息,解码器部分的前3次上采样前均通过金字塔池化模块,并融合浅层特征图,使得上采样时,既包含了图像深层特征信息又包含了图像的浅层信息,同时保留随网络的加深而失去的小目标地类,模型最终通过Sigmoid分类函数进行建筑物分类和提取。

|

| 图 4 融合多特征改进型PSPNet模型结构 |

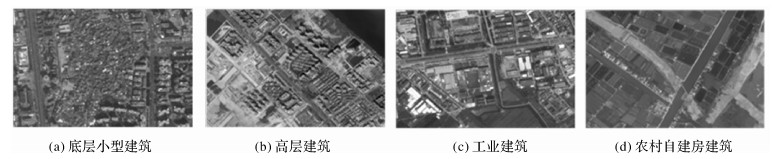

本文数据是利用法国普莱雅卫星于2019年10月采集的广东省珠海市的卫星遥感影像,该数据场景复杂,如图 5所示,包含城中村小型低层建筑、高层建筑、工厂建筑及农村自建房建筑,场景和建筑物的多样性增加了识别难度。影像包含4个波段(红、绿、蓝及近红外),空间分辨率为0.5 m,图像大小为10 000×10 000像素,覆盖地表面积为25 km2,选取4幅遥感影像进行人工标注,另选3幅作为测试数据。为防止内存溢出,增加训练样本,本文通过增加噪点、模糊、旋转、镜像等操作进行图像增强,并剪切成3万张大小为576×576像素的图像,其中75%用于模型训练,25%用于模型验证。

|

| 图 5 遥感影像中建筑物的复杂类型 |

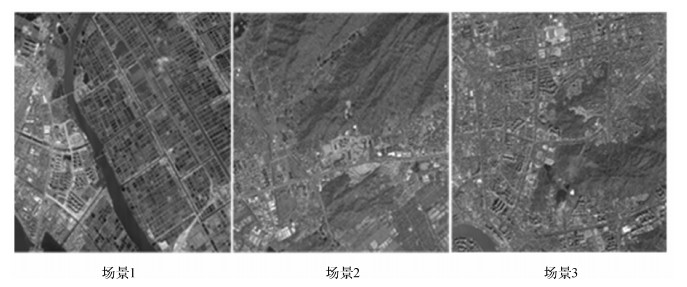

本文试验采取的测试集数据包括3张遥感影像,如图 6所示,其中,场景1中建筑物面积约占6.05%,该影像建筑物类型较为复杂;场景2以城中村小型建筑为主,建筑物面积约占7.82%,此场景用于检验模型在低矮、分布密集且占地面积小的建筑物上的识别精度;场景3以高层建筑为主,建筑物约占该幅遥感影像的17.82%,用于检验本文模型在高层建筑物上的识别精度。

|

| 图 6 测试数据集 |

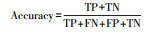

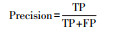

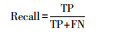

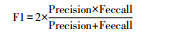

本文的训练网络均通过Python语言中的Keras深度学习框架实现,试验设备采用的显卡为RTX 2080ti,显存为11 GB,Python版本为3.6,Keras版本为2.2.5。经过多次试验,模型选取了效果最佳的损失函数,即分类交叉熵函数Categorical_crossentropy,优化器选择Adam算法进行网络参数更新。本文评价模型采用混淆矩阵的方法,选取总体精度、精确度、召回率、MIoU及F1值作为像素级语义分割的评价指标,见表 1。

| 名称 | 公式 | 含义 |

| 总体精度(Accuracy) |  |

计算预测结果中正确的像素占总像素的比值 |

| 精确度(Precision) |  |

预测结果中正类占总正类的比例 |

| 召回率(Recall) |  |

所有正类中被预测为正类的比例 |

| F1值(F1) |  |

衡量分类器的综合性能,F1越高说明模型越好 |

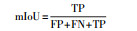

| mIoU |  |

各类别的IoU计算累加后进行平均,得到全局评价 |

| 注:TP为将正类预测为正类数;FN为将正类预测为负类数;FP为将负类预测为正类数;TN为将负类预测为负类数。 | ||

从表 2可以看出,U-Net模型预测总体精度高、时间短且建筑物提取精度可达0.718 7。PSPNet的精度可达0.701 4。U-Net模型融合了深层和浅层遥感影像的特征图并进行上采样,有效地解决了因网络的加深所导致的小目标建筑物丢失现象。本文融合多特征改进型PSPNet模型在测试集上的预测精度高于其他方法。该模型在编码器部分采用了ResNet[13]模块进行遥感影像的特征采集;膨胀卷积部分可通过扩大卷积的感受野而获取更多的特征信息;模型在上采样部分通过金字塔池化模块可获取更多结合上下文信息,有效地提高了模型精度,其精度较U-Net网络提高6%。

| 方法 | 时间/min | Accuracy | Precision | Recall | F1 | mIoU |

| U-Net | 0.97 | 0.955 3 | 0.718 7 | 0.834 8 | 0.772 4 | 0.790 4 |

| SegNet | 1.65 | 0.922 3 | 0.392 4 | 0.754 8 | 0.516 3 | 0.633 5 |

| PSPNet | 1.37 | 0.949 3 | 0.701 4 | 0.794 5 | 0.745 1 | 0.769 5 |

| PSPNet_multiple | 1.95 | 0.959 4 | 0.749 5 | 0.849 1 | 0.796 2 | 0.808 7 |

| 新模型 | 2.01 | 0.959 0 | 0.777 7 | 0.824 3 | 0.800 4 | 0.811 3 |

U-Net模型对低层建筑物提取结果表现较好,但易将高层建筑物的立面误判为建筑物。PSPNet的提取精度与U-Net相近,能有效地判别出高层建筑物,但低层建筑物提取结果轮廓模糊破碎,提取效果差。融合多特征的PSPNet模型(PSPNet_multiple)在PSPNet网络的基础上,融合了浅层图像特征,可有效解决低层建筑提取结果精度低的问题。新模型增加了膨胀卷积模块,该模块不仅增加了低层建筑物的识别精度,同时也加强解决高层建筑物预测结果不完整的问题,能够有效地提高复杂场景下的建筑物提取精度,结果见表 3。

本文构建的融合多特征改进型PSPNet模型在3幅测试影像上的预测精度有明显区别,见表 4。场景1复杂且建筑物种类多样,建筑物预测精度可达80%,预测精度明显高于场景1和场景2。场景2以城中村小型低层建筑物为主,模型在预测中受到建筑与建筑之间的阴影,以及建筑物之间的道路影响,其预测精度为75%。场景3以高层建筑和占地面积较大的建筑为主,预测精度可达78%,超过该模型的平均预测精度,但模型在预测中,将影像中的高架桥误判为建筑,对建筑物预测精度有所影响。

本文提出了一种融合多特征的改进型PSPNet模型,该模型适用于复杂场景下高分辨率遥感影像的建筑物提取,其精度均比U-Net、SegNet、PSPNet等模型的预测精度高。融合多特征改进型PSPNet模型中的膨胀卷积模块和金字塔池化模块有助于模型获取图像上下文信息,获取较为完整的高层建筑物轮廓,而融合多特征层可有效保留小目标建筑物,能有效提高小型低层建筑物的提取精度,适用于复杂场景下的建筑物提取。虽然本文的方法可有效地提取复杂场景下的建筑物,但预测结果仍存在误判和结果不完整,预测精度有上升的空间,提取特征阶段可选择其他的CNN网络,以提高模型的预测精度。

| [1] |

谢嘉丽, 李永树, 李何超, 等. 利用灰度共生矩阵纹理特征识别空心村损毁建筑物的方法[J]. 测绘通报, 2017(12): 90-93, 102. |

| [2] |

吴剑, 陈鹏, 刘耀林, 等. 震害损毁建筑物高分辨率遥感信息提取方法[J]. 地理与地理信息科学, 2013, 29(3): 35-38, 47, 2. |

| [3] |

HUANG X, ZHANG L. An SVM ensemble approach combining spectral, structural, and semantic features for the classification of high-resolution remotely sensed imagery[J]. IEEE Transactions on Geoscience and Remote. Sensing, 2013, 51(1): 257-272. DOI:10.1109/TGRS.2012.2202912 |

| [4] |

GHANEA M, MOALLEM P, MOMENI M. Automatic building extraction in dense urban areas through GeoEye multispectral imagery[J]. International Journal of Remote Sensing, 2014, 35(13): 5094-5119. DOI:10.1080/01431161.2014.933278 |

| [5] |

WANG J, YANG X C, QIN X B, et al. An efficient approach for automatic rectangular building extraction from very high-resolution optical satellite imagery[J]. IEEE Geoscience and Remote Sensing Letters, 2015, 12(3): 487-491. DOI:10.1109/LGRS.2014.2347332 |

| [6] |

HUANG X, ZHANG L P. A multidirectional and multiscale morphological index for automatic building extraction form multispectral GeoEye-1 imagery[J]. Photogrammetric Engineering and Remote Sensing, 2011, 77(7): 721-732. DOI:10.14358/PERS.77.7.721 |

| [7] |

胡荣明, 黄小兵, 黄远程. 增强形态学建筑物指数应用于高分辨率遥感影像中建筑物提取[J]. 测绘学报, 2014, 43(5): 514-520. |

| [8] |

FAN J L, XU W, WU Y, et al. Human tracking using convolution neural networks[J]. IEEE Transactions on Neural Networks, 2010, 21(10): 1610-1623. DOI:10.1109/TNN.2010.2066286 |

| [9] |

LONG J, SHELHAMER E, DARRELL T, et al. Fully convolu-tional networks for semantic segmentation[C]//Proceeding of IEEE Conference on Computer Vision and Pattern Recognition. Washington D C: IEEE Computer Society, 2015.

|

| [10] |

RONNEBERGER O, FISCHER P, BROX T. U-Net: convolu-tional networks for biomedical image segmentation[C] //Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015.

|

| [11] |

HU J, SHEN L, ALBANIE S, et al. Squeeze-and-excitation networks[J]. IEEE Transaction on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.1109/TPAMI.2019.2913372 |

| [12] |

ZHAO H S, SHI J P, QI X J, et al.Pyramid scene parsing network[C]//Proceeding of the 2017 IEEE Conference on Computer Vision and Pattern Recognition.New York: IEEE, 2017.

|

| [13] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//Proceeding of IEEE Conference on Computer Vision and Pattern Recognition. Washington D C: IEEE Computer Society, 2016.

|

| [14] |

陈凯强, 高鑫, 闫梦龙, 等. 基于编解码网络的航空影像像素级建筑物提取[J]. 遥感学报, 2020, 24(9): 1134-1142. |

| [15] |

张浩然, 赵江洪, 张晓光. 利用U-net网络的高分遥感影像建筑提取方法[J]. 遥感信息, 2020, 35(3): 143-150. |

| [16] |

刘钊, 廖斐凡, 赵桐. 基于PSPNet的遥感影像城市建成区提取及其优化方法[J]. 国土资源遥感, 2020, 32(4): 84-89. |

| [17] |

刘亦凡, 张秋昭, 王光辉, 等. 利用深度残差网络的遥感影像建筑物提取[J]. 遥感信息, 2020, 35(2): 59-64. DOI:10.3969/j.issn.1000-3177.2020.02.010 |

| [18] |

SHAO Z F, TANG P H, WANG Z Y, et al. BRRNet: A fully convolutional neural network for automatic building extraction from high-resolution remote sensing images[J]. Remote Sensing, 2020, 12(6): 1050. DOI:10.3390/rs12061050 |